オフラインデータを利用したロボット学習アルゴリズムの開発

昨今,深層学習を用いた画像認識技術や言語処理技術が様々な業界に大きくなインパクトを与えてきました. 産業構造を変えようとしている数々のAIモデルは,ビッグデータの恩恵を受け汎用的な特徴量の学習に成功していることが特徴の一つとして挙げられます. 深層学習を用いた画像認識は大規模なデータセットを用いて汎用的な特徴量を抽出し,多様なタスクに適応できる.

一方で,深層強化学習は,深層学習を用いて認識だけではなく意思決定を行う枠組みであり,囲碁でトップ棋士に勝利したAlphaGoをはじめとして注目が高まっています. 強化学習で用いられる環境との相互作用の繰り返しによる学習は,自動運転や医療分野といった試行錯誤が危険な現実世界への応用が難しいと考えられています.

そこで,画像認識技術のように事前に集めた大規模なデータセットから汎用的な特徴量を学習できる強化学習の技術開発が期待されています..

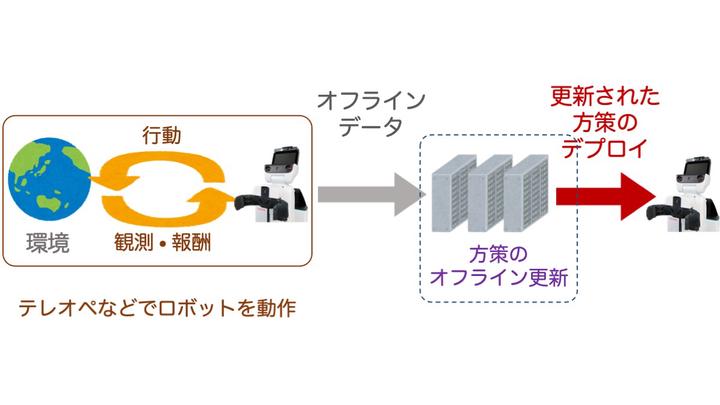

オフライン強化学習は,学習時に環境と相互作用をせずに,事前に集めたデータセット(オフラインデータ)のみを用いて意思決定を行うモデルを学習する強化学習の枠組みです. 環境へのアクセスをせずに学習できる性質は,大規模なデータセットを学習に活用でき,試行錯誤が許されない多くの実世界の課題を解く上で非常に望ましいと考えられます . その一方で,学習に用いたオフラインデータと,学習した方策を環境にデプロイした時の差異がモデルの精度に大きく影響し,大きな課題となっています.

TRAILでの最近の研究成果としては,”Deployment-Efficient Reinforcement Learning via Model-Based Offline Optimization"(ICLR2021に採録)が挙げられます. このプロジェクトでは,実世界応用を目指す強化学習において実世界へのデプロイ回数が重要な指標であることを指摘し,デプロイ効率という概念を提案しています. 提案手法であるBREMENは,方策をBehavioral Cloning方策で初期化を行った上で,パラメータを保守的に更新する機構を導入したモデルベースの手法であり,高いでデプロイ効率を実現しています. 詳細は,論文をご覧ください.