IROS2023に参加して発表しました

IROS2023@Detroit, USAに参加してきました.

はじめに

みなさん初めまして,機械工学科ベンチャー研4年の上條です.触覚やF/Tセンサを用いてコンタクトリッチマニピュレーションの研究に取り組んでいます.

先日,TRAILが東大で開講しているプロジェクト演習型講義人工知能応用プロジェクトの成果として,ロボティクス分野のトップカンファレンスであるIROS2023のWorkshop on World Models and Predictive Coding in Cognitive Roboticsに参加・発表してきました.

今回は,現地の様子や参加したワークショップについてお届けしたいと思います.

ロスバゲ

デトロイトは治安が悪いと聞いていたので覚悟はしていたつもりだったのですが,着陸して数分,自分のポスターがロストバゲージに遭いました.同じフライトで多くの日本人研究者がポスターを預けていたので,誰か間違えて取って行ってしまったのだろうと思っていたのですが,「飛行機に積まれた記録はあるけど飛行機から出た記録がない」とのことでした.このように航空会社にシンプルに紛失されることもあるので,初日発表の場合は(少し高いですが)布で印刷して折りたたんで手荷物に入れるのが無難かもしれません.私の発表は最終日だったので,なんとか現地で印刷するために即日印刷できる近くのお店を調べて連絡を取ったりして,初日と二日目は気が気じゃありませんでした.幸い,三日目の夜に航空会社から「見つかったで」とメールがあり,その30分後に空港から直接ホテルにポスターが届けられました(急に迅速な対応).

会場

会場はアメリカ・デトロイトのHuntington Placeというところでした.カナダを対岸に臨むデトロイト川に面しており,セッションの合間に多くの参加者が外に出てリラックスしていました. デトロイトの街は基本的にうるさくて,スピーカーで爆音で音楽を聴きながらドライブ・サイクリングをする陽気な人が多かったです.夜は危険なので基本団体で動いてUberで移動をしていました.

Workshop on World Models and Predictive Coding in Cognitive Robotics

参加したワークショップでは,世界モデルと自由エネルギー原理,ロボティクスについて,様々な観点から双方の繋ぎこみや今後の方向性について盛んに議論が行われました.

自分の研究では,実世界の問題を解決するためのEngineeringとしてのロボットとその学習技術を考えることが多いのですが,このワークショップでは人間を理解するためのScienceとしてのロボットを考える時間になり,大変興味深かったです.

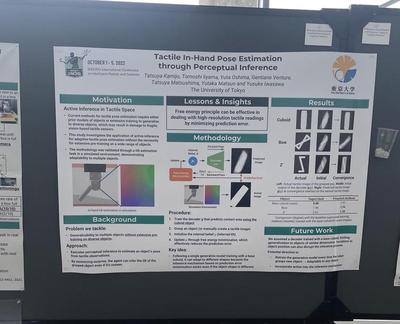

私は"Tactile In-Hand Pose Estimation through Perceptual Inference"という題目でSpotlight talkとポスター発表を行いました.

マニピュレーション分野では,近年の光学式触覚センサの発達により,触覚を利用した物体操作の研究が盛んに行われてきています.

しかし,学習データにない物体に対する汎化性能が課題となっていました.

今回の発表では,触覚のPerceptionを自由エネルギー原理の下に定式化し,予測誤差最小化に基づいて姿勢推定を行うことで,学習データにない物体に対しても適用可能なIn-hand Pose Estimationの手法を提案しました.

”Biologically Plausible"な触覚情報処理に興味を持っていただき,Spotlight・ポスター両方で,認識に加えて行動も組み込むためにはどうすればいいか,などの質問をいただき,有意義なディスカッションができました.

本会議

本会議は午前と午後それぞれで前半オーラル,後半ポスターと分かれており,オーラルで気になった発表をポスターで直接詳しく聞きにいくというスタイルをとることができて良い形式でした.コーヒーを飲みながらポスターを回れるのもとても好きです.ちゃんとデカフェも用意されていてありがたい. 松尾研からは黒木さんが“Collective Intelligence for 2D Push Manipulations With Mobile Robots”を発表しました.

本会議で気になった研究・発表の一部を挙げます.

- Active Acoustic Sensing for Robot Manipulation

- Shihan Lu and Heather Culbertson

- 振動アクチュエータから発されて掴んでいる物体を通過した振動の波形を圧電マイクロフォンで拾ってobject classification,grasping point estimation, object pose estimaitonできる

- 外部の音の影響は受けないらしい

- 大きな平面を持った時にほぼ情報が得られないという触覚センサのlimitationを突破しうる

- AcousTac: Tactile sensing with acoustic resonance for electronics-free soft skin

- Monica S. Li and Hannah S. Stuart

- 壊れやすい物体も掴めるsoft skinでできた触覚センサ(ソフロボ+tactile)

- 共鳴チャンバー内の空気圧による音の周波数変化で柔軟なエンドキャップの力をセンシング

- 別日に発表されていた上の論文とタイトルが似ていたので,名前すごく似てる発表見ましたと話しかけてみたら,それ他の人にも言われたわと言っていました.Tactileやってる人はTacitle一通り見てますね.

- Force Map: Learning to Predict Contact Force Distribution from Vision

- Ryo Hanai, Yukiyasu Domae, Ixchel G. Ramirez-Alpizar, Bruno Leme, Tetsuya Ogata

- 人間の「この辺に大きな力がかかっていそうだからこの辺を持とう」と予測できる能力を模倣

- RGBから力の分布を推定

- Simulation + Domain Randomizationにより,simは粗くてもそれなりの精度で実画像1枚から力の分布を推定できる

- Augmentation Enables One-Shot Generalization In Learning From Demonstration for Contact-Rich Manipulation

- Xing Li, Manuel Baum, Oliver Brock

- シングルデモを利用し,タスク遂行に必要な情報・trajectory constraintsを抜き出すためのdata augmentationをvisionとcontactについて行うことでcontact-richタスクを学習

- demonstrationにタスクの完全な情報が入っているとは限らない(筆者の主張)ので,必要な情報を知るためにロボットが自分で動いてデータを増やす必要

- 未だタスクの事前情報を用いているが,同じタスクでは背景の色や場所,外乱にロバスト(タスク遂行に必要な情報を取れているため)

- Plenary Talk: Yuto Nakanishi, GITAI

- GITAI 中西さんのプレナリー

- 最初に"No neural networks, many videos of robots moving"を宣言して会場大歓声

- 本当に一時間の講演中ほとんどの時間ゼロから作ったロボットが歩いたり転んだりしていた

- 失敗からは絶対に学ぶことがある,失敗してなんぼ

- ロボットはお金がかかる,宇宙では宇宙飛行士にかなりのお金がかかるのでロボットによる自律作業は大きな需要

以前ICRA2023@Londonに参加したときに面白かったポスターの写真を撮っておく文化があることを知って今回実践してみましたが,こうやって振り返ることができるので良いですね.

まとめ

研究の知見を広げることができただけでなく,以前からお世話になっている方と再会できたり,新たに多くの繋がりができたりと,ネットワークの面でも非常に充実したIROSになりました. 関わってくださった皆様,ありがとうございました.またどこかでお会いしましょう!

以上,IROS2023の参加報告でした.